¿Cómo nos comunicamos con la IA para generar música?

Escribir de música es como bailar de arquitectura . (Frank Zappa)

EL MURO. SOBRE LA IMAGEN Y EL SONIDO

Imaginemos que necesitamos crear un prompt, para que Midjourney “imagine” la casa de esta fotografía.

¿Cómo describiríamos esta paisaje para que Midjourney se inspirara? Pequeña casa de campo, con tres ventanas, un pequeño porche en la estrada cubierto con las mismas tejas rojizas que la casa, un pequeño torreón rojo al otro lado de la casa coronado por una pequeña cruz blanca, la casa está en la cima de una colina mirando un lago azul turquesa, al otro lado del lago vemos las faldas de montañas impresionantes moteados por lejanas casas de campo...

Ahora imaginemos que tenemos que explicar, el tema Highway to Hell de AC/DC. ¿Podríamos explicar con palabras una tema musical? NO. Podemos explicar un suceso, un sentimiento, un paisaje o la contabilidad de una empresa, pero no podemos explicar una música.

¿Qué prompt escribimos para que una IA dedicada a la música nos entienda?

¿Cómo describiríamos Hisgway to Hell de AC/DC?

De esto hablo cuando hablo del muro, nos faltan palabras, y lo grave que esta falta nos dificulta la comprensión, la imaginación y la transmisión de ideas sonoras . Pero eso ya pasaba antes de la irrupción de la IA. Experimentamos mejor la vida si tenemos palabras para describirla, el lenguaje articula la forma de mirar y sin lenguaje vemos menos. En el caso de la música , sin palabras "escuchamos menos".

INICIOS DE LA GENERACIÓN DE MÚSICA CON IA

La música al ser un lenguaje codificado y estándar, fue uno de los primeros campos donde se trabajó con la IA.

En los años 50, Lejaren Hiller y Leonard Isaacson, de la Universidad de Illinois, crearon un programa informático para crear música de forma automática, con él crearon la Illiac Suite. Aquí puedes escuchar uno de los movimientos

Lejaren Hiller y Leonard Issacson pioneros de la composición musical por ordenador.

Supongo que has pinchado en el link y lo estás escuchando, mientras sigues leyendo. Esta es la primera composición que se realizó con un ordenador. El tipo de composición es muy de la época, parece que lo hubiera creado un Stravinsky evolucionado.

¿Suena bien, verdad?, sencillo, son personas interpretando. En aquella época la IA primitiva generaba la partitura y los humanos la interpretaban. Más tarde aparecieron los sintetizadores y los samplers. Y con esto muchos investigadores trabajaron en la línea de generar composiciones con ordenador.

Y ahora van saliendo aplicaciones y más aplicaciones con mucha IA y otras con no tanta IA... pero todas venden IA.

MI EXPERIENCIA CON LA GENERACIÓN DE MÚSICA CON IA

La primera plataforma con la que trabajamos fue AIVA, “Creé” mi primera música con AIVA en 2019. Fue un poco frustante, no había muchas opciones y el resultado era pobre. Ahora empezamos a ver soluciones más ágiles y creativas.

Podéis escuchar la evolución a AIVA, desde la primera Composición que generé el 12 sept 2019 Piano solo, hasta una hecha hace cuatro días.

AIVA ha ido mejorando sus capacidad de generar, pero sobre todo ha mejorado la interface con el usuario. Para mí este es el gran escollo en la generación musical con IA, ¿cómo nos comunicamos con la IA para generar música?

Soundraw deja editar la música para "dibujar" la evolución que necesites en la música.

Pero antes quiero abordar un tema principal sobre la creación audiovisual aplicada al audiovisual.

¿REALMENTE SABEMOS LO QUE QUEREMOS ?

Normalmente NO sabemos lo que queremos cuando buscamos un música para unirla con una imagen, buscamos una sensación, sabemos dónde queremos llegar, la impresión que queremos transmitir, pero no conocemos el camino a este lugar. Para esto están los compositores de bandas sonoras.

La mejor forma es tener referencias; ejemplos de temas musicales ( música cómo...) o experiencias audiovisuales ( una sensación cómo las Walkirias en Apocalypse Now). Al fondo lo que queremos copiar son sensaciones, no temas musicales.

Apocalyse Now, imágenes que acompañaban a la Cabalgata de las Walkirias de Wagner.

Aquí aparece una pregunta ¿podrá algún día la IA crear un estilo nuevo y aceptado como bueno por los humanos? Copiar podrá, pero crear algo completamente nuevo, ¿un estilo musical?

¿CÓMO SALTA LA IA EL MURO DEL LENGUAJE?

Pues los programadores hacen lo que pueden, de momento copian el sistema de la música de archivo, que es una aproximación burda pero más o menos funciona.

Mood ( alegre, elegante, épico...), género ( pop, clásico, rock, latino...), tema (documental, drama, comedia, horror...), Instrumentos ( piano, guitarra, voz, sintetizador...)

De momento los sistemas más completos parametrizan la música siguiendo estos items... aunque no todos llegan tanto la detalle. Aun así es un sistema muy pobre por que la base de la música es el tiempo, la evolución los cambios, la intensidad y la dirección.

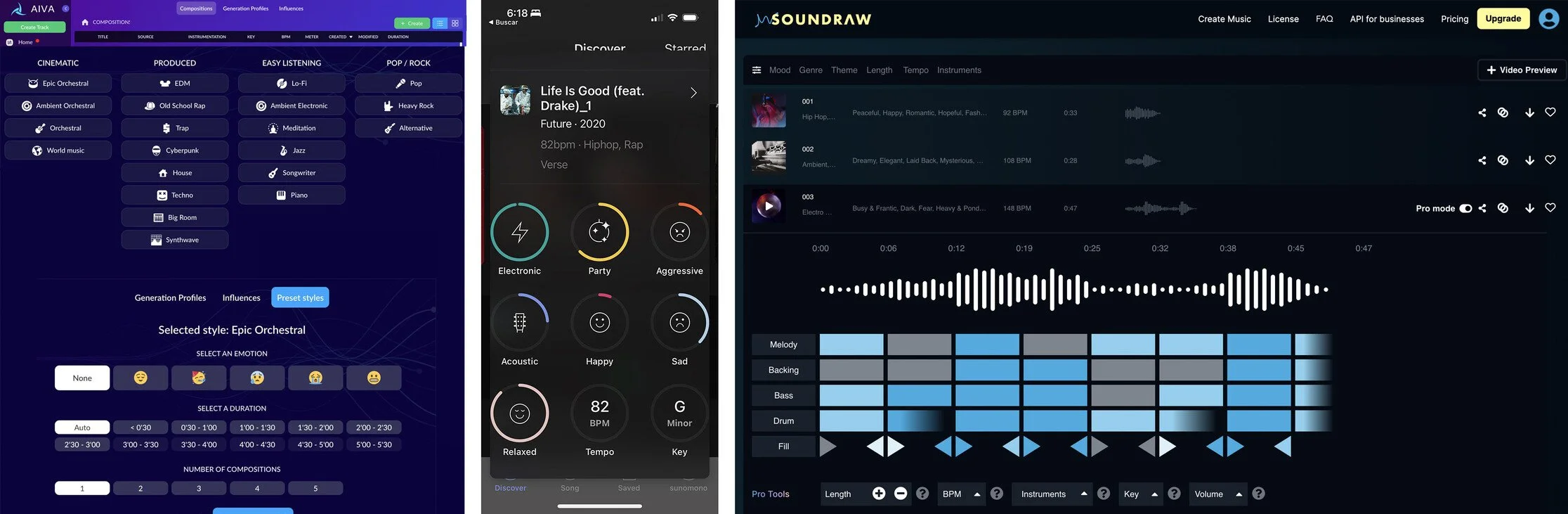

Diferentes interficies para comunicarnos con la IA. Por orden AIVA, Amadeus Code, Soundraw

MÚSICA DE REFERENCIA PARA INSPIRARSE

En sonido siempre nos hemos apañado trabajando con referencias. Quiero algo parecido a este tema, o a este fx…

Relacionarnos con referencias musicales es un parche, sería ideal tener la capacidad de “explicar” un tema musical con palabras y que lo pudiéramos imaginar.

Actualmente AIVA a mejorado la interface añadiendo un módulo que permite subir un fichero de audio para "inspirarse" para crear nueva música, pero de momento los resultados no son satisfactorios, de todas formas es un muy buen camino, para trabajar con la música generativa.

Puse el tema Highway to Hell a AIVA y el resultado que más se pareció fue esto:

Puede parecer una broma, pero esto es lo que lo devuelve actualmente... todo cambiará, pero no he encontrado una aplicación que sea el "Midjourney" de la música. No dudo que saldrá antes del verano algo muchísimo mejor, pero todavía no lo he encontrado.

He visto varias entradas en redes sociales, que esplican lo rápido que se hace todo, incluída la música, cuando te pones te das cuenta que no... que falta.

MI EXPERIENCIA HASTA LA FECHA.

De momento ( mayo del 2023) no he encontrado la máquina de hits que todos soñamos. La música con IA no tiene la capacidad de imitar a un humano componiendo... pero todo llegará. Mientras ya podemos utilizarla como "colchón" en muchos videos de formación o similar.

Mi sensación es que los programadores se han fijado demasiado en el lenguaje musical y no tanto en la forma de onda, aunque incomprensible para el humano intuyo que el deep learning puede sacar resultados interesantes. El problema es que las imperfecciones visuales, son texturas que nos dan vida... y las imperfecciones sonoras crearían un batiburrillo de arritmias desentonadas que convertirían la experiencia musical en algo muy desagrabable, pero todo llegará.

Y ¿LOS DERECHOS?

Ya tendremos tiempo de hablar de los derechos sobre las músicas creadas con IA más adelante.